Definition des Begriffes Augmented Reality (AR)

Unter Augmented Reality (dt. "Erweiterte Realität") versteht man die Erweiterung der tatsächlichen Welt durch virtuelle Elemente. Folgende, aus dem alltäglichen Leben gegriffene, Analogie soll dem Verständnis von Augmented Reality dienlich sein:

Bei der Echtzeit-Fernsehübertragung eines Fußballspiels sind neben dem wirklichen Geschehen meist Spielstand und Spieldauer eingeblendet. Zusätzlich werden bei Freistößen oft die Distanz zwischen ausführenden Fußballspieler und Tor in Echtzeit angezeigt. Derartige Details sind der realen Welt nicht zu entnehmen und stellen damit eine Erweiterung der Realität dar. Wenn man dabei den Aspekt der Dreidimensionalität außer Acht lässt ist dies ein triviales Beispiel für AR.

Die erweiterte Realität stellt eine Verschmelzung aus realer und virtueller Welt dar und bringt eine Vielzahl neuer technischer Möglichkeiten in vielen Anwendungsbereichen, unter anderem in der Medizin.

Per Definition (Azuma, 1997) muss ein AR-System drei Kriterien erfüllen:

- Die virtuelle Realität und die Realität sind miteinander kombiniert (teilweise überlagert)

- Interaktivität in Echtzeit

- Reale und virtuelle Objekte stehen 3-Dimensional zueinander in Bezug

Da sich diese Definition allein auf technische Merkmale stützt und somit lediglich einen Teilaspekt von AR abdeckt, werden an dieser Stelle auch noch andere Definitionen zitiert. So wird AR auch als eine Ausweitung der Sinneswahrnehmung des Menschen durch Sensoren von Umgebungseigenschaften, die der Mensch selbst nicht wahrnehmen kann, wie Radar, Infrarot oder Distanzbilder und andere definiert.

Gerne wird in Arbeiten auf die Definition des Begriffes Realität verwiesen und in Frage gestellt, ob sich die so verstandene Realität überhaupt erweitern lässt.

Auditive Realitätserweiterung

Teilt etwaige, normalerweise an den Computer gebundene, Information dem Nutzer auditiv mit. So können eingegangene Emails gemeldet werden oder wichtige Termine in Erinnerung gerufen werden. Die zwei wesentlichen Vorteile sind zum Einen, dass der der Nutzer seine Umgebung nicht permanent analysieren muss, wie dies bei der Form der visuellen Erweiterung der Fall ist, zum Anderen interagiert er weiterhin mit der realen Welt, ohne durch die Verwendung von Hilfsmitteln eingeschränkt zu sein und doch wird seine subjektive Realität erweitert.

Haptische Realitätserweiterung

Haptische Realitätserweiterung meint die Miteinbeziehung des Tastsinns. Hierbei soll also die virtuelle Welt um haptische Sinneseindrücke ergänzt werden. Die Idee dahinter ist jene, dass der Nutzer bei der Berührung eines Objektes haptisches Feedback erhält, sprich die Beschaffenheit der Oberfläche ertasten kann. So würde sich Glas etwa kalt und glatt anfühlen, Holz im Gegenzug dazu eher warm und rau zu erfassen sein.

Zudem kann das Aufeinandertreffen verschiedener Materialien realitätsnah imitiert werden, wie ein Experiment aus der Medizin verdeutlicht. Ken Hinckley (1994) verwendet dabei zur Simulation des Einschnittes in menschliches Gewebe eine Plexiglasplatte, die ein Skalpell imitiert, sowie einen Gummiball zur Nachahmung des einzuschneidenden Körpers. In Kombination mit der visuellen Erweiterung kann so ein realistischer Eindruck vermittelt werden.

Visuelle Realitätserweiterung

Durch die Kombination der realen Welt mit virtuellen Objekten, durch das Einbinden von virtuellen Objekten in die reale Umgebung oder durch die Erweiterung der virtuellen Welt durch reale Elemente wird diese Form der Realitätserweiterung verstanden.

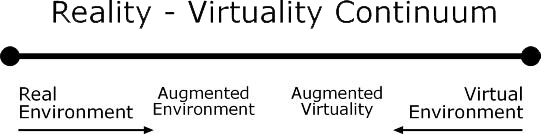

Die so erweiterte Darstellung der Welt soll allerdings nicht mit der virtuellen Umgebung (virtual environment) verwechselt werden. Die reale Umgebung ist die Welt wie wir sie kennen, die virtuelle Umgebung ist vollständig unwirklich und enthält keine realen Elemente. Die Erweiterte Realität kann demnach als Spezialfall der gemischten Realität gesehen werden, wie nachfolgende Abbildung von Milgrams Reality-Virtuality Continuum zeigen soll.

Reality-Virtuality Continuum von Milgram und Kishino

Grundlegende Komponenten eines AR Systems

Die wesentlichen Komponenten eines Augmented Reality-Systems bestehen einerseits aus einem Interaktionssystem, das mit Hilfe von Eingabegeräten eine Interaktion zwischen dem Benutzer und dem AR-System ermöglicht, andererseits aus einem Trackingsystem, welches für die exakte Übereinstimmung zwischen realer und virtueller Szene sorgt und letztlich einem Darstellungssystem, mit dessen Hilfe der Betrachter die erweiterte Realität angezeigt bekommt. Ein angeschlossenes Computersystem verbindet die Komponenten, so dass der Betrachter in die erweiterte Realität eintauchen kann.

Interaktionssystem

Für die Interaktion werden hauptsächlich zwei Komponenten, Dateneingabegeräte und Selektionswerkzeuge, benötigt. Im Anschluss werden Möglichkeiten der Umsetzung aufgezeigt.

Dateneingabe

Der Tinmith-Datenhandschuh ist für die Selektion gleichermaßen wie für die Dateneingabe geeignet. Dieser Handschuh besteht aus einem normalen Gärtnerhandschuh, um dessen Fingerspitzen, Daumen und Handflächen ein Metallband gewickelt ist, um eine metallische Oberfläche herzustellen. Kabel verbinden die Oberflächen mit einem Rechner. Auf jedem der Finger sind Sensoren zur Ermittlung der Fingerposition und Fingerkrümmung angebracht. Ebenso befinden sich Sensoren auf der Handfläche, welche die Neigung der Hand registrieren. Mittels eines Trackingsystems kann so die genaue Position der Finger, sowie Neigung der Hand berechnet werden. Ebenso werden Bewegungen registriert. Mit diesem Werkzeug kann die Dateneingabe umgesetzt werden.

Durch das Zusammendrücken von einem oder zwei beliebigen Fingern und dem Daumen wird ein ASCII Zeichen aus einer vordefinierten Matrix ausgewählt. Wird beispielsweise der Zeigefinger und Mittelfinger der rechten Hand auf den rechten Daumen und der Ringfinger der linken Hand auf den linken Daumen gedrückt wählt man den Buchstaben „P“ aus. So kann ein kurzer Text ohne zusätzliche Eingabegeräte geschrieben werden. Auf ähnliche Weise wird die Menüauswahl realisiert. Hier wird ebenso wie bei der Texteingabe durch das Zusammendrücken von Finger und Daumen oder Finger und Handballen ein Menüpunkt ausgewählt.

Selektionswerkzeuge

Für die Selektion stehen nur virtuelle Objekte zur Auswahl, da reale Objekte wie gewohnt verändert oder bewegt werden können. Bowman und Hodges unterteilen die Selektionswerkzeuge in zwei Kategorien. Ray-casting (Strahl-Auswahl) und arm-extension (Gummihand) Technik.

Die arm-extension Technik funktioniert nach dem Prinzip einer Gummihand. Dabei sieht der Benutzer nicht mehr seine reale Hand sondern eine virtuelle. Liegt ein Gegenstand außer Reichweite der physischen Hand kann ihre Länge nach Belieben verändert und somit jedes virtuelle Objekt erreicht werden. Die Armlänge kann man dabei auf zwei verschiedene Arten, durch das Drücken einer Taste oder durch die Bewegung der realen Hand, verändern.

Bei der ray-casting Technik erscheint ein virtueller Zeigestab als Verlängerung eines beliebigen realen Fingers, idealerweise des Zeigefingers. Schneidet der Zeiger ein virtuelles Objekt, wird durch Drücken einer Taste dieses ausgewählt und an das Ende des Zeigestabs gehängt. Somit kann der Gegenstand verschoben und gedreht werden.

Für die Manipulation ist die arm-extension Technik wesentlich besser geeignet, da weiterhin die Hand für die Bearbeitung eines virtuellen Objektes verwendet wird. Bei der ray-casting Technik hingegen wird die Manipulation stark eingeschränkt. Aufgrund des Hebelarmes der durch den Zeigestab entsteht kann der virtuelle Gegenstand schwer um eine andere Achse wie um die des Zeigestabes gedreht werden.

Trackingsystem

Die realen Objekte, die Bestandteil einer AR-Anwendung sind müssen in Lage und Position erfasst werden können. Nur so können virtuelle Informationen an der richtigen Stelle eingeblendet werden. Diese Aufgabe übernimmt das Tracking. Es gibt erfasste Informationen über Objekte und Betrachter an ein Computersystem weiter. Mittels Matrix-Transformationen errechnet dieses die exakte Position, welche vom Darstellungssystem zur Ausgabe benötigt wird. Durch korrekte Berechnung und Verarbeitung dieser Informationen wird eine für den Betrachter deckungsgleiche Darstellung erreicht. Aus diesem Grund müssen Trackingsysteme sehr genau arbeiten, schon kleinste Fehler fallen dem Betrachter auf und behindern die Arbeit. Zudem ist es von Belang, dass die Systeme eine hohe Reichweite besitzen, da sich der Betrachter möglichst uneingeschränkt bewegen können soll.

Heutige Tracking-System basieren auf unterschiedlichen Techniken. Die gebräuchlichsten Technologien arbeiten auf optischer Basis. Sie liefern präzise Ergebnisse und besitzen eine hohe Reichweite. Andere Systeme "tracken" Objekte elektromagnetisch, mit Ultraschall oder mechanisch.

Ein optisches Tracking-System, beispielsweise das System "Polaris" von NDI, erfasst die Umgebung mit optischen Kameras. Das System orientiert sich dabei an bestimmten Landmarken, mit deren Hilfe die Objekte erfasst werden. Landmarken können entweder natürlicher Beschaffenheit sein, z. B. Nasenspitze oder Augenwinkel, oder eben künstlich. Die künstlichen Landmarken lassen sich wiederum unterteilen: Aktive Landmarken sind in diesem Fall LEDs, die in regelmäßigen Abständen blinken, oder auch batteriebetriebene Marker. Als passive Landmarken kommen so genannte Retrokugeln zum Einsatz.

Darstellungssystem

Grundsätzlich können die Techniken der Informationswiedergabe in zwei Kategorien, nämlich Brillen-basierte und Monitor-basierte Darstellungen, unterteilt werden. Die Vereinigung von realer und virtueller Welt kann bei See-Through Displays auf zwei verschiedene Arten erreicht werden. Im Anschluss werden die Geräte zur Darstellung von Informationen näher betrachtet.

Brillenbasierte Systeme

Die brillenbasierten Systeme lassen sich vereinfachend in drei Kategorien aufteilen.

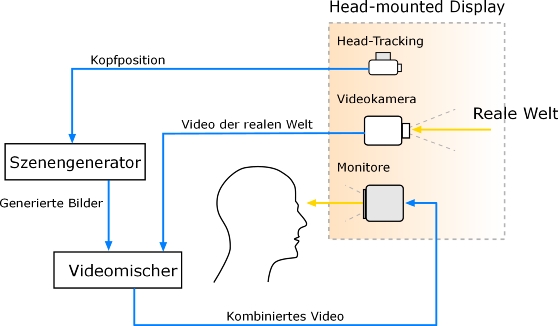

Video See-Through Head-Mounted Displays

sind so aufgebaut, dass vor den Augen des Betrachters zwei Monitore angebracht werden, welche die, mit Hilfe der ebenfalls an der Brille befestigen Videokameras aufgenommene , reale Szene abbilden. Zusätzlich zur realen Szene werden dann die virtuellen Informationen angezeigt.

Schematische Darstellung von Video See-Through Head-Mounted-Displays

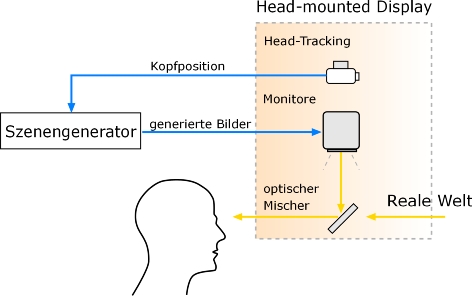

Optische See-Through-Head-Mounted Displays

ermöglichen durch einen gekippten, halbdurchlässigen Spiegel vor den Augen des Betrachters den direkten Blick auf die reale Szene. Monitore, die oberhalb des Spiegels angebracht sind, überlagern das reale Bild mit virtuellen Informationen.

Schematische Darstellung von Optischen See-Through Head-Mounted-Displays

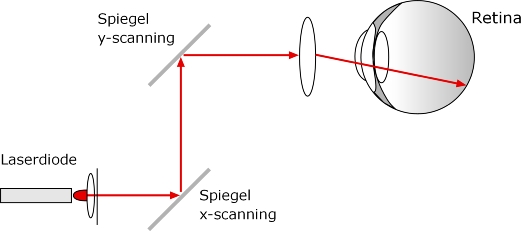

Retinal Scanning Displays

sind Brillensysteme, die virtuelle Informationen direkt auf die Netzhaut des menschlichen Betrachters projizieren. Die Bauweise ähnelt derer der HMDs, wobei die Monitore durch einen oder mehrere Laser ersetzt werden. Bildprojektoren malen mit Hilfe dieser extrem schwachen Laserstrahlen Grafiken in schnellen Pulsen auf die Netzhaut des Auges. Als Bildquelle kann eine Kamera oder ein Computer angeschlossen werden. Bildpunkt für Bildpunkt wird dann - ähnlich wie beim Fernsehen - in einzelnen Zeilen auf die biologische Leinwand übertragen. Ein Prototyp des Verfahrens wird derzeit an der Universität Baylor in Texas klinisch erprobt.

Schematische Darstellung von Retinal Scanning Displays

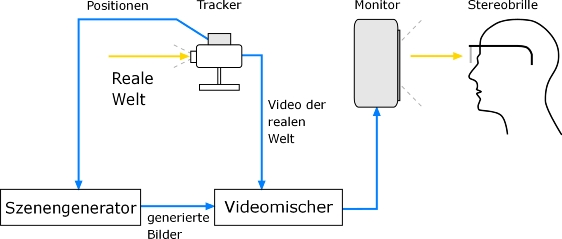

Monitor-basierte Systeme

Die Monitor-Basierte Umsetzung der Informationspräsentation erfolgt ähnlich wie bei der des Video See-Through HMD. Die reale Welt wird durch eine Kamera eingefangen und mit der virtuellen kombiniert. Lediglich die Ausgabe unterscheidet sich grundlegend von der der Video See-Through HMDs. Sie erfolgt über einen beweglichen oder starren Bildschirm.

Schematische Darstellung von Monitor-basierten Darstellungs-Systemen

Anwendungsgebiete der Augmented Reality

Augmented Reality-Systeme können in vielen verschiedenen Bereichen zu den unterschiedlichsten Zwecken eingesetzt werden, wobei die Medizin wohl einen der wichtigsten und zukunftsträchtigsten Bereiche darstellt. Die Fülle an Anwendungsbeispielen ist enorm. Im Folgenden werden nur einige mögliche Bereiche und jeweils ein Beispiel dazu erwähnt.

Produktion und Instandhaltung:

Augmented Reality bietet die Möglichkeit, große, komplexe Maschinen leichter herzustellen, zu warten und zu reparieren, indem einem Monteur im Schaltplan oder in der Bedienungsanleitung verzeichnete Informationen oder Arbeitsanweisungen in die reale Szene eingeblendet werden. Es besteht also die Möglichkeit, Fehler schneller zu finden und korrekt zu beheben, ohne wichtige Schritte zu übersehen oder gar zu vergessen.

Entwicklung und Konstruktion:

Mit Hilfe der Augmented Reality erhalten die Kunden einen vorausschauenden, dreidimensionalen Anblick des neuen Produkts oder ihrer Konstruktion. Zudem kann jeder Teilnehmer "live" mit dem neuen Produkt in Interaktion treten. In Echtzeit können dann Designer, die sich nicht zwingend in einem Raum mit dem Kunden befinden müssen, sondern über eine AR-Konferenz mit Ihnen verbunden sind, bestimmte Bereiche des neuen Produktes markieren und ändern.

Unterhaltung:

Als bekanntes Beispiel können die Wetteraussichten genannt werden. Ein Moderator steht im Studio vor einer blauen Wand ("Blue Box"). Der Zuschauer erkennt alle Farben, Szenen, Formen, etc., jegliche Bilder oder Spezialeffekte können eingeblendet werden, die der Zuschauer dann anstelle der blauen Wand sieht.

Verbraucher-Design und Mode:

Es besteht die Möglichkeit, neue Frisuren bewundern zu können, bevor sich der Friseur überhaupt ans Werk macht. Ein Kleidungsstück wird dem Kunden im Geschäft mittels erweiterter Realität anprobiert und dann entsprechend maßgefertigt. Auf diese Weise kann garantiert werden, dass Geschmack und Größe exakt den Kundenwünschen entsprechen.

Militär:

Kampfpiloten erhalten während des Fluges Informationen, wie zum Beispiel Entfernungen zu feindlichen Objekten oder Flugdaten, via Displaytechnologie direkt in das Sichtfeld eingeblendet. Aber auch zum Training am Boden könnte Augmented Reality eingesetzt werden, um Kosten schonend realitätsnahe Übungen zu absolvieren.

Verlauf

Verlauf

Alle Kapitel anzeigen

Alle Kapitel anzeigen